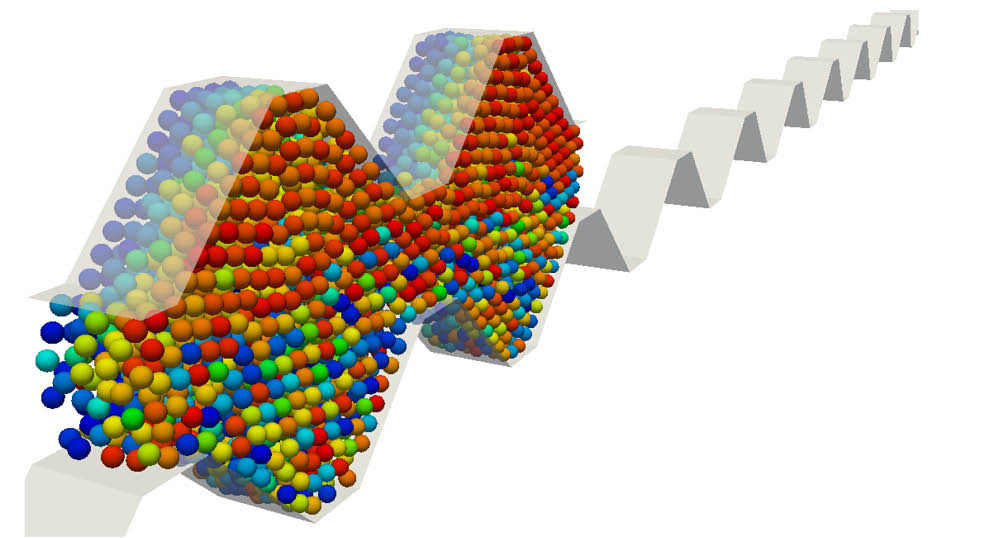

High-Performance-Computing

Seit seiner Gründung hat sich das Institut für Computational Engineering (ICE) als kompetenter Ansprechpartner für die Anwendung anspruchsvoller mathematischer Methoden in den Ingenieurwissenschaften etabliert. Im Rahmen zahlreicher Industrie-Projekte, viele davon öffentlich gefördert, konnte das Spezialisten-Know-How „Simulation und Modellbildung“ vom ICE zum Industrie-Partner transferiert werden. Worum geht es?