In der alpinen Rettung kommt es zu Situationen, in denen die Retter mit den herkömmlichen Suchmethoden wie Hunden oder Helikoptern wetter- oder geländeabhängig an ihre Grenzen stossen. Die Bergretter erhalten deshalb neuerdings Unterstützung aus der Luft: Rettungsdrohnen zeichnen während des Fluges Videos auf, die anschliessend von mehreren Bergrettern auf einem Bildschirm angeschaut werden. Die Retter finden so Personen oder Objekte, die einen Hinweis auf das Verbleiben einer vermissten Person geben können. Dieser manuelle Prozess ist allerdings anstrengend und zeitaufwendig.

In ihrer Bachelorarbeit im Studiengang Informatik versuchten Cyrill Hänni und Dominik Kessler herauszufinden, ob dieser Prozess mit Software unterstützt bzw. automatisiert werden kann.

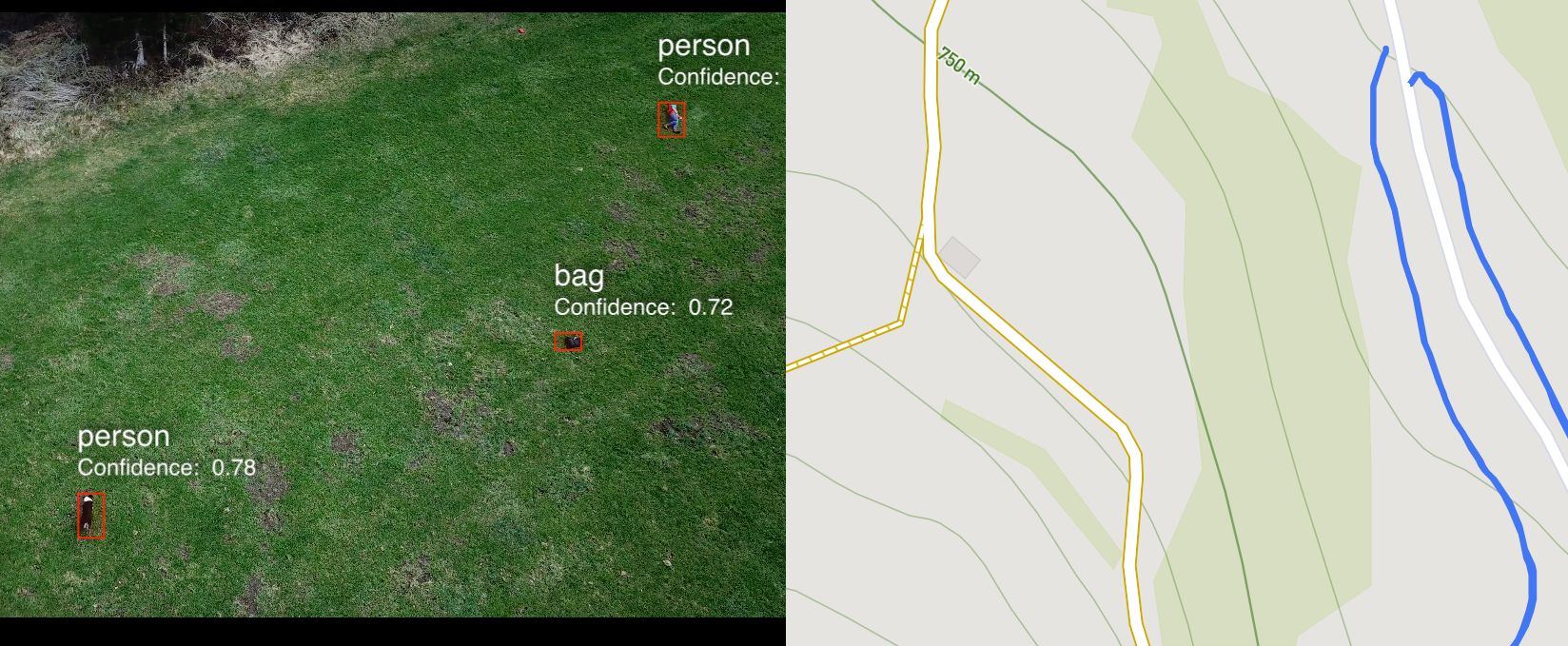

Dazu setzten sie das sogenannte «Deep Learning» ein, eine Methode des maschinellen Lernens. Basierend auf gestellten Videos, welche die beiden HSR (heute OST) Studenten mit Hilfe von Projektpartnern aufgenommen haben, trainierten sie mit Deep Learning ein Modell, das auf die Erkennung der gesuchten Personen und Objekte spezialisiert ist. Dieses Modell kam nicht nur in der macOS-Applikation zum Einsatz, die beiden Studenten integrierten es zusätzlich in einer iOS App. So kann während des Drohnen-Flugs der Live-Videostream analysiert werden und dem Piloten werden in Echtzeit Hinweise zu vermissten Personen angezeigt.

«Wir konnten eine macOS-Applikation entwickeln, die die Objekte mit Hilfe von Deep Learning findet», schreiben die beiden Informatik-Studenten im Abstract zu ihrer Arbeit. «Zusätzlich wurde die bestehende iOS Applikation, welche zur Kontrolle des Drohnenflugs eingesetzt wird, so erweitert, dass der Livestream der Drohne in Echtzeit analysiert werden kann.» Die macOS-Anwendung durchsucht Videodateien und zeigt dem Benutzer übersichtlich an, wo im Video etwas erkannt wurde. Hänni und Kessler haben somit bewiesen, dass es möglich ist, Objekte und Personen innerhalb einer nützlichen Frist in Videodateien zu finden.

«Diese Neuerungen werden den Einsatz der Rettungsdrohnen optimieren», sind die beiden Studenten überzeugt. Die Projektpartner und Betreuer Prof. Dr. Farhad Mehta arbeiten bereits an Ideen für weitere Arbeiten, die von Studierenden durchgeführt werden können.

Projektpartner waren die Namics AG und Beutler-Coaching. Das Projekt wurde von Prof. Dr. Farhad Mehta betreut und von den beiden HSR (heute OST) Informatikstudenten Cyrill Hänni und Dominik Kessler umgesetzt.

Abstract der Bachelorarbeit «Videoanalyse für fliegende Rettungshunde»